Groupon a fait un test : la désindexation du site pendant 6 heures. Le trafic naturel chute évidemment, mais un grande part du

trafic direct tombe également (60% dans le test). Une part du trafic considéré comme direct est en réalité du trafic naturel.

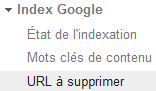

En savoir plus Par les Webmaster Tools de Google, demander la suppression d’un URL / répertoire / site complet est la méthode la plus rapide.

Site : Followerwonk de Moz – 300,000 URL supprimés en 3 heures. Le rétablissement du site a pris le même temps.

L’outil ne désindexe pas réellement un URL. Il le masque seulement des résultats de recherche pour 90 jours maximum. Pour définitivement désindexer une page, il faut la supprimer du site ou utiliser la balise robots.

Par les Webmaster Tools de Google, demander la suppression d’un URL / répertoire / site complet est la méthode la plus rapide.

Site : Followerwonk de Moz – 300,000 URL supprimés en 3 heures. Le rétablissement du site a pris le même temps.

L’outil ne désindexe pas réellement un URL. Il le masque seulement des résultats de recherche pour 90 jours maximum. Pour définitivement désindexer une page, il faut la supprimer du site ou utiliser la balise robots.

L’apparition des sitelinks d’un site dans les résultats de recherche de Google dépend principalement de son ancienneté, donc de son poids pour Google par rapport à la requête. La sélection des pages qui s’affiche est théoriquement ce que Google considère comme important dans le site, souvent les pages du Top Menu. On peut donc difficilement influencer son choix. L'unique chose que l'on maitrise :

bloquer l’apparition d’une page précise en sitelink par les Webmaster Tools (Apparence dans les résultats de recherche > Liens de site).

L'avis d'Axe-Net sur le sujet

Dans les

Webmaster Tools, une nouvelle section est apparue, l'Outil de test du fichier Robots.txt. Cette fonction permet de tester si une URL du site est bloquée par le fichier, et signale si des erreurs de syntaxe y sont présentes.

L'annonce officielle de Google sur le sujet

Juin – disparition de la photo de l’auteur

Août – disparition complet de l’authorship

Conçu à l'époque pour mettre en avant un contenu identifié par son auteur, donc qualitatif pour l'internaute, l'

authorship Google est supprimé. Identifier son contenu n'est désormais plus utile, ni la photo ni le nom de l'auteur n'apparaitront dans les résultats de recherche. Une explication non-officielle serait que les photos d'auteur attireraient trop l'oeil de l'internaute, donc son clic, au détriment des annonces publicitaires AdWords. Google aurait donc un manque à gagner pour lui-même et ses clients AdWords.

Les sites sécurisés seront privilégiés «

à l’avenir ».

Actuellement, aucun bonus n’est constaté.

https://www.abondance.com/actualites/20140807-14164-les-sites-securises-https-seront-mieux-positionnes-google.html

https://www.abondance.com/actualites/20140905-14242-https-pas-davantage-linstant-en-seo-etude.html

Un site one-page est-il mauvais pour votre SEO ?

Avant de développer un site SEO, il est important de penser au SEO.

Sur le site

flowerbeauty.com, vous pouvez voir que chaque section du site est présentée sur une même page mais correspond à une URL différente, donc référencée séparément. Ceci est un exemple de site développée avec le SEO en tête.

Vous pouvez tester avec la commande « site:https://flowerbeauty.com/ » sur Google qui vous montre bien que toutes les rubriques du site sont bien indexées.

Les explications techniques

La mise à jour Panda 4.1 est en ligne depuis fin septembre. Cette nouvelle version favorise d'avantage les sites de qualité de tailles petite et moyenne. Les règles habituelles de Panda restent valables : des pages de contenu trop faible (moins de 100 mots) ou dupliqué seront exposées..

Cette version favorise les petits et moyens sites de qualité (28e version)

Site sanctionné si :

- pages trop faibles (<100 mots) - texte dupliqué (>30% avec une autre page) - bourrage de mots-clé

Google a mis à jour Penguin et est passé à la version 3.0 dans la nuit du 17 au 18 octobre 2014. Cette mise à jour consiste entre autre à pénaliser les backlinks artificiels. Le déploiement de cette mise à jour se fera sur plusieurs semaines.

Source :

WebRankInfoGoogle affiche déja des données enrichies (rich snippets) dans ses résultats de recherche. Il remonte désormais des

extraits structurés issues des fiches produits, lorsque ces données sont structurées sous forme de tableaux. Les exemples les plus courants sont dans le domaine industriel. La requête "

capteur de force" affiche un résultat probant.

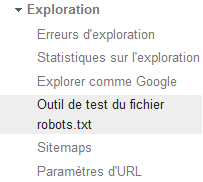

En savoir plus Sur Google est récemment apparu un champ de recherche interne dans les SERP. Il apparait spontanément pour les plus gros sites. Mais cette fonctionnalité n'a pas que des avantages : il faut la paramétrer avec les consignes officielles, sinon la requête devient « [mot-clé] + site: » , ce qui affiche une 2e page de résultats qui risque d'afficher des publicités AdWords, donc de détourner le trafic initial qui comptait pourtant accéder à un site donné.

- Reconnaissance du contenu des images, par éléments distincts.

- Lecture du texte des images (opérationnel mais pas généralisé)

- Utilisation des données EXIF

Positionnement d’une image actuel : balise ALT + proximité du mot-clé dans la page (ex : pizza aux anchois – test de SEO pour confirmer que Google ne comprend pas le contenu d’une image)

Google évolue technologiquement sur la

reconnaissance du contenu des images, par éléments distincts. Il aura pour but de lire du texte des images (opérationnel mais pas encore généralisé) et d'utiliser leurs données EXIF (dans le cas des photos). Pour l'instant, le positionnement d'une image sur un mot-clé dépend de sa

balise ALT + proximité du mot-clé dans la page (ex :

pizza aux anchois – test de SEO pour confirmer que Google ne comprend pas le contenu d’une image).

L'explication sur le blog de recherche GoogleGoogle a officiellement déclaré qu'il prendra en compte l'optimisation d'un site pour mobile pour son bon référencement. Afin de proposer une expérience utilisateur optimale pour les mobinautes, il est en mesure de juger si l'ergonomie d'un site est adaptée ou non et le signale dans les résultats de recherche par un picto ou un texte.

Un

outil de test de compatibilité mobile officiel est déja en ligne.

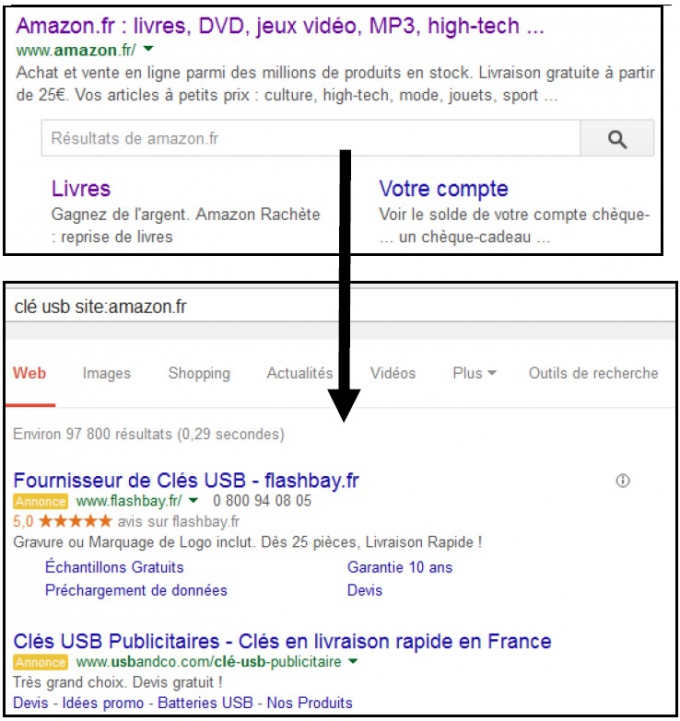

Google annonce qu'il ne faut pas bloquer les

CSS et JavaScript à l’exploration afin que ses bots puissent indexer un site le mieux possible, et le voir comme le voit réellement un internaute. Google ignorera désormais les pages en mode "statique" et évaluera les pages lorsque tout le code CSS et JavaScript sera chargé.

Les Webmaster Tools de Google proposent l'outil

Explorer comme Google, qui signale les ressources bloquées (souvent par le fichier Robots.txt).

Il est possible d'afficher des

caractères spéciaux dans les meta-descriptions pour qu'ils s'affichent dans les résultats de recherche Google. Pour cela, il faut inclure ces caractères avec du code Unicode. L'idée est d'attirer l'oeil de l'internaute, en restant mesuré pour que Google ne les ignore pas.

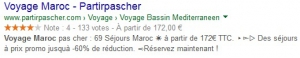

Consulter une liste complête.Récemment constaté dans les SERP de Google, une exception à la règle des 156 caractères sur 2 lignes pour les meta-descriptions. On constate cette anomalie dans les secteurs très concurrentiels, par exemple les voyages low-cost.

Voyez par vous-même.

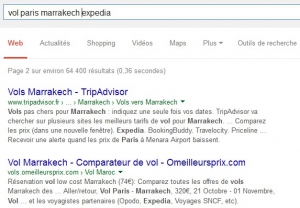

L'outil

Screaming Frog SEO Spider permet de de tester si un Title ou une Description sera trop long pour Google, donc coupée dans les SERP (limite de caractères ou de pixels). Il permet également de lister toutes les pages d’un site avec Title ou Description trop longs, manquants, ou en double. Plus fiable que la fonction dédiée de Google dans les Webmaster Tools. La

version d'essai est gratuite.

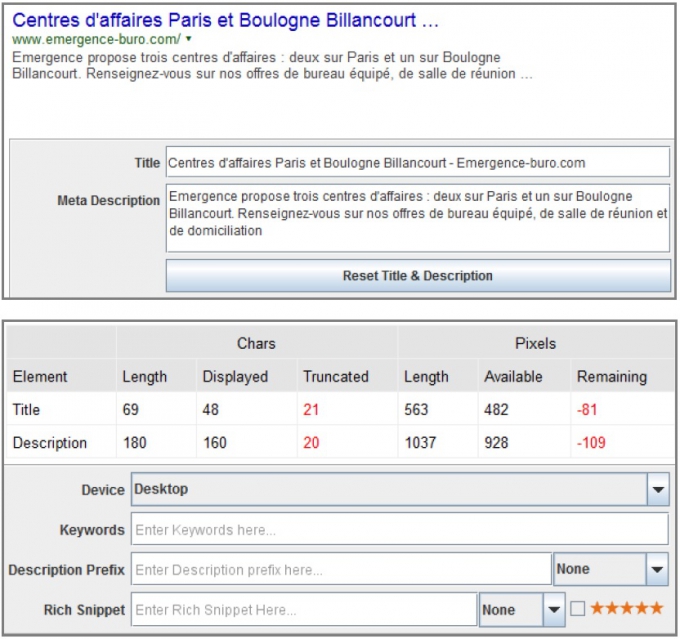

Une des sources de trafic alternatives au référencement naturel peut en dépendre directement : des images bien optimisées sur votre site

se positionnent sur Google Images, au fonctionnement différent de Google. Pour certaines reqûetes, Google affiche dans ses résultats naturels un carrousel d'images (en réalité un extrait des premières positions de Google Images). Se positionner sur Google Images permet ainsi d'être en

première page.

Comment suivre ce trafic ?Cette nouveau option Facebook permet de mieux cibler son

segment rentable, permet une réelle segmentation marketing par la technologie utilisée. On peut donc choisir quel smartphone ou tablette sera visé par une publicité précise, si son site ou son application mobile est d'avantage adaptée à un terminal (ou inadaptée à un autre).

En savoir plusPlutôt que de soumettre ses nouveaux utilisateurs au remplissage d'un formulaire complet et fastidieux, certains sites (e-commerce, actualités) permettent la création de comptes par les réseaux sociaux, qui reprennent alors les informations déja enregistrées. Facebook est en tête de ces plugins, avec 55% des connexions, Google+ est à 27%

Des précisions

L'une des fonctionnalités la plus attendue et demandée par les utilisateurs est enfin disponible après plus d'un an de test chez Facebook. Il est en effet enfin possible d'enregistrer un article pour pouvoir le relire plus tard.

Des détails chez Presse-CitronFacebook a mis en place un système de tracking des visites des sites internet par ses membres pour savoir quelles publicités insérer dans le fil d'actualité lorsqu'ils reviennent sur Facebook. Comme toute solution de

remarketing / retargeting, ce système permet d'afficher des publicités plus pertinentes mais est en contrepartie plus intrusif.

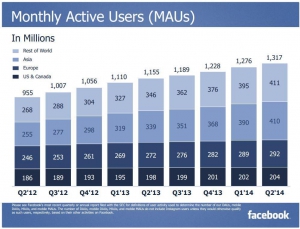

Plus d'informations à ce sujetFacebook a au second semestre 2014 :

- plus d'1,32 milliards d'utilisateurs,

- dont 1 milliard sur mobile,

- avec 829 millions de comptes actif.

Ses revenus publicitaires s'élèvent à 2,68 milliards de dollars et 1 milliard de dollars de résultat net.

Les derniers résultats financiers de Facebook

Pinterest a lancé une nouvelle fonction permettant aux utilisateurs de

discuter via une messagerie instantanée.

Cette fonction est plutpot un moyen de partager des "Pins" ("épingles") de manière confidentielle, et ainsi d'en discuter en privé.

01netSnapChat est la troisième application la plus utilisée chez les 18-34 ans aux USA, à hauteur de 33%, derrière Instagram (43,1%) et Facebook (75,6%). Les comportements de cette classe d'age est proche de ceux en France, souvent avec une année de décalage. Les solutions publicitaires sont également en développement chez Snapchat, pour l'instant en test pour certains annonceurs.

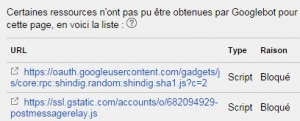

Plus de détails chez TechCrunch Chaque réseau social propose désormais ses solutions payantes, afin de démarquer ses messages de la masse.

C'est Twitter qui performe le mieux : les Tweets sponsorisés ont un taux de conversion de 160% comparés aux Tweets classiques (3,9% en sponsorisé et 1,5% en classique). Facebook présente des performances équivalentes entre les messages naturels et les payants. Pinterest n'est qu'aux début de ses services payants, expliquant les taux plutôt faibles.

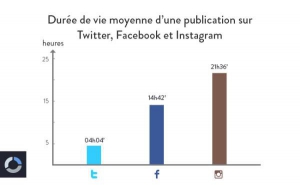

Plus d'informationsLa durée de vie d'une publication varie en fonction du réseau social utilisé. Les écarts sont forts, mais logiques. Twitter affiche l'intégralité des messages des comptes suivis, par ordre chronologique, et l'utilisateur est incité à publier d'avantage vu la limite de caractères (140). Facebook au contraire privilégie les messages développés et les trie par importance supposée.

- Twitter 4 heures

- Facebook 15 heures

- Instagram 21 heures

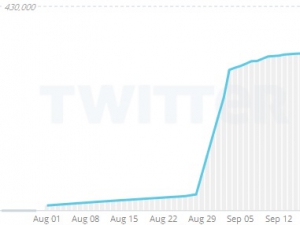

Le

compte Twitter d'Europe 1 a gagné près de 60 000 followers en ...six jours ! Il ne s'agit pas de followers achetés illégalement mais un recrutement de nouveaux followers via des

tweets sponsorisés. Les nouvelles solutions publicitaires de Twitter sont donc performantes.

En savoir plus Facebook a lancé un nouveau service qui permet de signaler à vos contacts Facebook que vous êtes en sécurité en cas de

catastrophes naturelles. Il se base sur votre géolocalisation pour vous inviter à signaler si vous êtes ou non affecté. Ce service a été imaginé par des ingénieurs japonais après la catastrophe de Fukushima en 2011, et reste pertinent en Asie du sud-est, régulièrement victime de typhons.

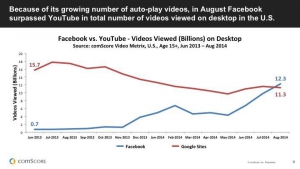

Un article de Rue89 sur le sujet Depuis la mise en place de la lecture automatique des vidéos, plus de vidéos sont visionnés depuis Facebook que sur YouTube.

Plus de 65% de ces visionnements se font sur mobile.

En savoir plus Google compte bientôt développer des annonces locales avec AdWords. Ce service se basera sur votre géolicalisation pour vous indiquer les boutiques offrant le produit recherché proche de chez vous.

En savoir plus Google offre un crédit de 10 000 $ en AdWords pour les associations loi 1901 ou des fondations d'utilité publique. Il permettra à ces assocations de faire la promotion de leurs missions en cours et à venir.

En savoir plus Comme les numéros de tel trackés dans les annonces dans Google, Google peut remplacer le numéro sur le site web par un numéro AdWords tracké (ajouter un script).

Ce service permet de tracker et mesurer si vos clients appellent votre entreprise et via quelle page. Il permettra de savoir via quelle page les clients contactent le plus votre entreprise.

En savoir plus L'application Google Analytics est enfin disponible sur votre téléphone (iOS et Android). Il vous permettra de consulter en temps réel les statistiques de votre site internet.

L'ergonomie a été pensé pour être clair et facile à utiliser.

En savoir plusDraprès le

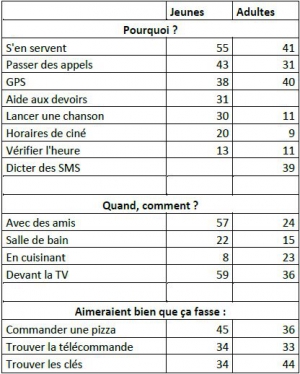

blog officiel de Google, la recherche vocale aux Etats-Unis est de plus en plus utilisé, notamment chez les adolescents, accessible via le désormais célèbre "OK Google!".

La recherche vocale est par exemple plus deux fois plus utilisé (57%) chez les adolescents contre 24% chez les adultes.

Au contraire, en faisant la cuisine seul 8% des adolescents utilisent la recherche vocale en faisant la cuisine alors que 23% des adultes l'utilisent.

Google Now répond correctement à 80% de questions comparé à 53% pour Siri et 40% pour Cortana.

Source :

StoneTempleLe "World Wide Web" fête ses 25 ans cette année et le web a récemment franchi la barre d'un milliard de sites. D'après Internet Live Stats, tous ces sites seraient actifs.

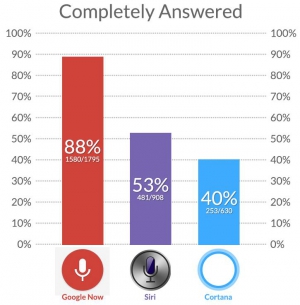

Plus d'informations sur Usine-Digitale 43% des changements de prix sont des hausses

- 50% des réductions durent moins de 2 jours

- 60% des produits inférieurs aux prix médians

- Concurrence forte = Prix + bas

Selon

le Journal du Net, 43% des changements de prix sont des hausses sur Amazon alors que 50% des réductions durent moins de 2 jours. Amazon n'est pas toujours le site e-commerce le moins cher mais 60% des produits d'Amazon sont inférieurs aux prix médians.

Plus la concurrence est forte, plus Amazon pratique des prix bas.

Grâce au HTML 5 et avec la technologie Javascript, il est possible d'avoir accès plusieurs articles sur la même page. Comme vous pouvez le constater sur cette

exemple, en scrollant la page, différents articles s'affichent et l'URL de la page se met à jour automatiquement.

Le problème de cette technologie est que même si l'URL se met à jour, Google Analytics se voit pas cela comme des pages distinctes. Il est cependant possible de corriger ce problème avec à quelques lignes de code.

Source :

builtvisible

![Google-Penguin-3.0[1]](/media/newsletters/google-penguin-3-0-1-2947-300x0.jpg)

![taux-conversion-social-organique-sponsorise[1]](/media/newsletters/taux-conversion-social-organique-sponsorise-1-2954-300x0.png)

![safetycheckmobielcarousel[1]](/media/newsletters/safetycheckmobielcarousel-1-2959-300x0.jpg)